1. 継続的な成長ができる:キャリア開発が鍵

特に、現在労働人口の半数以上を占めるミレニアル世代とZ世代の間で、ジョブホッピングが増加しています。しかし、ジョブホッピングが楽しいからではありません。労働者の約4分の1が、キャリアアップの機会が見いだせないために退職すると答えている一方で、83%は積極的に昇進を求めています。多くの従業員は、明確な将来性があれば、現在の組織にとどまることを好みます。また、社員が昇進だけを追い求めるのではなく、組織内での横方向の異動を希望する傾向が強まっています。今日の従業員は、成長、発展、新しいスキルの習得を熱望しており、現在の職務にそのような機会がなければ、他を探します。企業が優秀な人材を確保するためには、明確なキャリアパスを作り、継続的なスキルアップと能力開発の機会に投資する必要があります。

まず、社員の長期的なスキル(適応力、問題解決力、協調性など)を理解することから始め、そのインサイトを活用して能力開発計画を立案します。単に昇進のためだけではなく、社員が自分のポテンシャルを認められ、育まれていると感じられる職場を作ります。明確な成長経路を提示し、従業員一人ひとりの将来に投資することで、組織は長期的な忠誠心を築き、優秀な人材がいなくなるリスクを減らすことができるのです。

2. 人間性が評価される:AIにはないスキルがある

AIや自動化が職場で顕著になるにつれ、従業員は人間特有のスキル(共感力、創造力、適応力、批判的思考力)を評価されることを強く望むようになっています。AIはデータ分析や自動化を簡単にこなしますが、イノベーションを推進し、コラボレーションを促進し、最終的に組織文化を構築するのは行動的なスキルです。他者とつながり、批判的に考え、変化に適応する能力は、テクノロジーでは真似のできない紛れもない人間の強みです。従業員は、職場が進化する中でも、自分のポテンシャルが認められ、育まれ、個人と組織の成功の原動力となるヒューマン・スキルの開発に対する支援を求めています。

AI化が進む職場で、より人間中心の役割につきたいというニーズを満たすためには、組織は従業員の行動スキルと将来のポテンシャルをより深く理解する必要があります。単に現在の能力に基づいて人材と仕事をマッチングさせるだけにとどまりません。各個人の成長を予測し、変化に機敏に対応することを含みます。組織が従業員の強みと能力開発領域を明確に特定できれば、配置配属や能力開発について客観的で公平なデータに基づいた意思決定を行うことができます。

また、客観的な人材アセスメントによって、社員が気づいていない貴重なスキルを発見し、本人へ伝えることが可能です。例えば、「私たちは、あなたのこのようなスキルを見て、Xの役割への昇進を支援するためにこのスキルを伸ばしたいと考えています」といったオープンなコミュニケーションは、従業員とそのキャリアパスに対する真のコミットメントを示し、信頼を育むことにつながります。

3. 公正さの可視化:意思決定のプロセスを信頼する

公正さは今や単なる組織の理想ではなく、従業員の期待の中核となっています。多くの従業員にとって、信頼は透明性から生まれます。従業員は、人材がどのように決定されるかを知り、そのプロセスが公正で客観的であることを確信したいのです。従業員は、企業がDEIの取り組みにおいて、実際に測定可能な成果を示すこと、「有言実行」を期待しています。企業が声明を出すだけでなく、公正さを意思決定や職場文化に深く根付かせることで、信頼を築くことができます。人材に関する意思決定の基準や手順について透明性を提供し、組織のあらゆる行動において公平性と公正性を可視化することが求められています。例えば、採用においては、職務に関連した基準に基づく客観的なアセスメント、構造化された面接、偏見を減らすための多様な採用担当者の起用などが含まれます。スキルベースの採用は、従来の資格ではなく、職務に関連する能力に焦点を当て、より幅広い人材に目を向けることできるようになります。候補者にとっても、過去の実績だけでなく今現在の職務に何をもたらすかが評価されるため、これまでアクセスできなかった職務への道を切り拓く助けになります。

4. 適応を助けること:絶え間ない変化は疲弊するため、サポートが必要

従業員は常に適応が求められる状態にあり、最後の変化が完全に導入される前に次の変化がやってくることが多いです。変化は単に早く起こっているだけでなく、終わりが見えず、継続的に起こっているのです。その影響は明らかで、最近の調査では、どの人事リーダーも、従業員が変化に対する疲労に苦しんでいると報告しています。また、変化の渦中にサポートが得られていないと感じたまま放置された従業員は、安定性を求めて他の職場を探す可能性が54%高くなるという調査結果もあります。また、留まる人々も、しばしば自分自身がやる気を失い、燃え尽き症候群の危険にさらされ、ついていくのに必死であることに感じています。そのため、従業員が変化の流れに巻き込まれるのではなく、職場環境をコントロールできていると感じるためには、サポート、透明性、そして本当の意味での主体性が不可欠です。組織は、従業員が変化の時代にサポートされていると感じられるような環境を整え、単に移行を管理するのではなく、適応できるようにしなければなりません。

まずは、変革を推進する人々が他者を指導できるスキルを持っているかどうかを検討します。SHLの最新リサーチでは、変革を成功させるために不可欠なスキルとして、「人のやる気を引き出し、力を与える」、「合意を得る」、「共感を示す」といった資質が挙げられています。これらの資質は、従業員が変革に投資し、変革を通じて互いに支え合うことを奨励する文化を育むことにつながります。

これらのスキルをアセスメントすることで、組織は、スキルの開発や強化が必要なのはどこかを判断し、レジリエンス(回復力)とアジリティ(敏捷性)を強化するための支援体制を整えることができます。積極的なアプローチをとることで、組織は、変化を受け入れる準備の整った人材を育成することができるのです。

5. 未来に向けて備えさせる:AIとともに進化する

AIは仕事を大きく変えつつあり、従業員はAIを活用するためのトレーニングやサポートを組織に期待しています。実際、リーダーの66%がAIのスキルを持つ候補者を好み、71%がAIに堪能であれば経験の浅い候補者でも採用したいと回答しています。労働者側を見てみると、知識労働者の75%がすでにAIを業務で使用しています。にもかかわらず、現在AIリテラシーに関するトレーニングを行っている企業は38%に過ぎません。役割の進化や新たな責任の発生に伴い、期待とトレーニングの不整合はリスクをもたらします。特にキャリアの浅い従業員にとって、AIへ習熟することは成長機会の拡大を意味し、リーダーの4分の3以上が、AIに習熟したキャリアの浅い人材は、より大きな責任を与えられる可能性が高いと回答しています。AIの役割が拡大し続ける中、従業員のサポート、スキル開発、役割への適応の必要性はかつてないほど重要になっています。AIは一部の仕事を容易にする一方で、新たな複雑さをもたらしています。LinkedInの調査によると、米国で最も急成長している職種の68%近くは、20年前には存在しなかったものです。実際、これらの進化する役割に必要なスキルは、主にAIによって、2030年までに68%変化する可能性があります。

このような新しい環境で成功するためには、従業員が責任を持って生成AIツールを使用するための明確なトレーニングが必要です。適切な指導がなければ、これらの強力なツールが誤って使用され、非効率的な、あるいは有害な結果につながる可能性があります。AIツールとトレーニングの両方に投資することで、組織は従業員が機敏で適切な生産性を維持できるようになります。企業にとって、AIの利点は生産性だけにとどまりません。チームを鼓舞し、今後の仕事に備えさせることでもあるのです。

AIを評価に用いる最大のメリットは「効率化」です。ソフトバンクではエントリーシート選考にAIを導入することでかかる時間を約75%削減できたとしています。

また人事評価では、AIを導入することで、人の手では処理しきれない複数の評価軸を用いて総合的に人材を判断し、より正確な評価を行ったり、隠れた人材を見つけ出したりすることが期待されています。

しかし、AIを用いた「評価」には既にいくつかの問題が生じていることも事実です。

事例1:アマゾンの人材採用AIが「女性差別」

米アマゾンは応募者の履歴書をチェックするAIを構築してきましたが、そのAIが「女性差別」をする傾向があると、2015年、判明しました。応募書類に『女性』や『女性チェスクラブに所属』などのキーワードが見つかると、採用対象から除外するというケースが発生したのです。これは、AIが学習したデータが、過去10年間の応募者データであり、「男性の応募者の方が有望」「女性は低く評価する」と学習してしまったために起こりました。

AIは過去のパターンから最適解や予測を導き出すようにできています。つまり、従来の社会構造が引き継がれてしまうのです。AIの使い方によっては、今の世の中にある偏見やバイアスが増幅されかねません。

事例2:日本IBMの「AI人事評価」は「ブラックボックス

日本IBMが人事評価と賃金決定にAIを導入しました。これに対して、同社の労働組合がAIの学習データや、評価者である上司にAIが表示するアウトプットの内容などの開示と説明を求めたところ、同社が拒否しました。労働組合は、不当な団交拒否と支配介入だとして、2020年に東京都労働委員会に救済を申し立てています。労働組合はAIによる不利益の可能性として次の4点をあげました。

- プライバシーの侵害 個人の業績や職務遂行能力以外の情報の収集や利用は、労働者のプライバシーを侵害する懸念がある。

- 公平性、差別の問題 会社の中で、優位性が高い立場にいる人に親和的な言動をとる人が高く評価され、逆の人は低く評価される懸念がある。

- ブラックボックス化 何が正しいかAIは判断できず、判断に至った過程を説明することができない。低評価を受けた従業員は、どのような理由で低評価になったのか分からないままでは、労働者の成長機会が失われる。

- 自動化バイアス(コンピューターによる自動的な判断を過信してしまう傾向) AIは人事評価を「サポート」するツールと位置付けるが、自動化バイアスが働き、マネジャーはAIに逆らえない可能性が高い。

(参考:https://www.bengo4.com/c_5/n_14490/)

これはAIによる賃金査定や人事評価をめぐる日本で初めての労使紛争です。ここで指摘している点は、企業が説明責任を果たしていないことです。AIが何を元に人事評価を行うのか、なぜ自分は高/低評価だったのか、そうしたことを従業員に説明できていないために係争になっています。

AIの課題

AIを評価に用いる際に最もネックとなることは「ブラックボックス化」です。評価の根拠がわからないため、もし、事例1のように誤った学習がされていてもそれに気付くことができない可能性があります。また、事例2のように評価の根拠を相手に説明することができなくなってしまいます。 特に「評価」の場面は、採用しかり、人事評価(昇進/昇格)しかり、相手の人生に大きく関わります。評価に納得がいかず説明を求めたのに、「AIがそう言ったから・・・」では、相手は受け入れられないでしょう。AIのメリットを生かすために

AIを評価に用いる際の懸念事項は見過ごせませんが、それでもAI導入による効率化は魅力的です。大前提として、AIは補助的なツールであり、その判断は絶対ではないという認識を持つ必要があります。実際に自分が被評価者を見て、判断することが大切です。それがAIの判断と異なっていた場合、AIの判断に納得がいかないのであれば自分の結論を優先させる、もしくは第三者に意見を仰ぎ、最終的な判断は「人間」が行うことが原則です。

内閣府の「人間中心のAI社会原則」(2019年3月)や総務省の「AI利活用原則(2019年8月)でも定められている通り、AIを利用する場合には意思決定とその結果に対する説明責任(アカウンタビリティ)があります。なぜ不採用になったのか、なぜ昇格したのか、それを説明できることが重要です。

AIには「忖度」もなければ「倫理観」もありません。あくまで確率で結果を出します。その判断をするためのデータにバイアスがないか、出された判断に納得のいく説明ができるかどうか、そうした部分は必ず人が確認をしなければなりません。

もっとも、最近では、AIのブラックボックス化を解消するために、過程や根拠を説明できるAIの研究も進められているので、将来的にはAIと相談しながら決定する時代が来るかもしれません。

おわりに

エントリーシート選考をAIで行う企業が増えている一方で、受検者側もAIを使ってエントリーシートを作成するようになってきています。受検者向けのサービスには、代わりにエントリーシートを書いてくれたり、添削してくれたりするAIも存在しています。 書くのもAI、評価するのもAIという、誰の何を何のために評価しているのかわからない時代になっているなと感じてしまうのは、私が世の中の変化についていけていないだけなのでしょうか。本質を見極める「評価」とは何だろうと日々考えてしまいます。

参考資料

山本 龍彦・大島 義則(2023).人事データ保護法入門 勁草書房

焦点:アマゾンがAI採用打ち切り、「女性差別」の欠陥露呈で

アマゾンの人材採用AIが「女性を差別した」理由を考えてみる

なぜ、アマゾンは「採用選考でAI利用」を辞めた?AIには推し量れない「人間ならではの事情」とは 【伊藤穰一】

IBM「AI人事評価」、元人事責任者も知らない全容 労使紛争、都労委で証人尋問

AI不当労働行為事件

無責任なAIの運用実態 都労委証人尋問報告

SHLディストリビューター・カンファレンス

2023年5月25日(木)と5月26日(金)の2日間、約5年ぶりに対面でのSHLディストリビューター・カンファレンスが開催されました。ディストリビューター・カンファレンスとは、世界のSHLディストリビューターが集い、各国の最新情報を交換し、親睦を深めるための会議です。今回は、13か国から約30名のディストリビューターが参加し、イギリス、サリー州ドーキングのWotton Houseで開催されました。

参加したディストリビューターは以下の通りです。(順不同)

・アジア

SHLインドネシア

アセスメントアナリティクス(フィリピン)

日本エス・エイチ・エル

・ヨーロッパ

SHLタレントアセスメントs.r.o(チェコ)

エヴァリオン SHLギリシャ・キプロス

SHLハンガリー

SHLポーランド

SHLポルトガル

SHLルーマニア

PEスペイン SHLスペイン

SHLトルコ

SHLウクライナ(オンライン参加)

SHLのディストリビューターは、各国でSHLディストリビューターとして、SHLサービスを専任で販売する契約を結んでいるアセスメント事業者です。かつてはSHLの子会社であったけれども資本関係がなくなりディストリビューターとなった会社や元々は異なるサービスやアセスメントを取り扱っていたがSHLディストリビューターとなった会社など様々な経緯の会社がいます。

当社は、2023年4月にSHLが約7割の資本を保有するグループ会社となりましたので、今回が最後のディストリビューター・カンファレンスとなります。

2つのプレゼンテーション

丸二日間のカンファレンスには、17の講演とセッション、ネットワーキングのためのランチとディナーと盛りだくさんのコンテンツがありました。講演とセッションは大きく3つのジャンルに分けることができます。1つ目はSHLの方針やサービスについてのCEOや各部門トップからの説明。2つ目は事例を各国のコンサルタントが話しました。3つ目は最新の研究・調査について各国の心理学者や研究員が発表しました。

これらのコンテンツの中で、私の興味をひいたのは以下2つのプレゼンテーションでした。

・SHL Labs Reimaging the Future of Talent / Kuldeep Yadav, PhD, Director of AI

AIディレクターのKuldeep Yadav氏によるAIを活用したアセスメントについて発表です。生成AIを活用した自動面接が多くの面接における問題点の解決に貢献できること、職務記述書から自動的に求められるスキルやコンピテンシーを定義できること、アセスメントの膨大なテクニカルマニュアルから、顧客向けの簡潔な資料を自動生成できることなどが紹介されました。実際にインドのSHLスタッフがAIによるアバターと面接する映像が流され、実用可能であることがよくわかりました。

・Gender Equality Journey / Susana Almeida Lopes, SHL Portugal Managing Director & Isabel Paredes, SHL Portugal Chief Psychologist

SHLポルトガルが行ったジェンダーイクオリティに関する調査についてのSHLポルトガル社長Susana Almeida Lopes氏とパートナー兼チーフサイコロジストIsabel Paredes氏による発表です。SHLポルトガルのジェンダーイクオリティに関する活動を報告するとともに、ジェンダーによるコンピテンシーの差があるかについての研究成果が示されました。彼女たちはポルトガルで2012年から2021年にかけて大規模な調査を実施しました。複数のアセスメント手法を用いて測定されたコンピテンシーに男女差が見られるかについての調査です。3つのアセスメント手法でSHLのUCFコンピテンシー(20項目)を測定しました。アセスメントセンターによるコンピテンシー測定ではコンピテンシーの男女差は確認できませんでした。シミュレーション演習(プレゼンテーション、ロールプレイ)によるコンピテンシー測定でもコンピテンシーの男女差は誤差の範囲でした。コンピテンシーのポテンシャルを予測するOPQ32rを用いたパーソナリティ測定においては、複数の項目で男女差が確認できました。

この研究結果をどのように捉えるべきかについては様々な点を考慮し慎重に解釈する必要がありますが、自己概念と行動について深く考えさせる内容でした。

SHLの未来

このカンファレンスでは、未来のSHLを示す多くのプレゼンテーションがありました。SHLのChief Executive OfficerであるAndy BradshawはSHLをソリューションベースのSaaSプラットフォームと定義し、様々なタレントデータの収集、可視化、活用による深いタレントインサイトで採用とタレントマネジメントの包括的なソリューションを行うという現在進行形のビジネスモデルを説明しました。その他にも、DEIの取り組み、ニューロダイバーシティの研究など、SHLソリューションの広がりを予感させるたくさんの情報が提供されました。

おわりに

今回は、SHLディストリビューター・カンファレンスの一部をご紹介しました。当社はディストリビューターからSHLグループの一員となりましたので、今後は各国の事例やグローバルな研究や新しいソリューションについて最新情報を提供してまいります。 今、話題沸騰中のChatGPT。あらゆる業務を効率化できるツールとして、様々な分野での活用がはじまっています。本コラムでは、ChatGPTが人事業務をどのように改善できるかについて、その可能性を考えていきます。ChatGPTとは

ChatGPTは、OpenAIが開発した人工知能技術を用いた自然言語処理のモデルです。大量のテキストデータを学習し、人間と同様の言語理解能力を備えています。ChatGPTは、テキストベースの対話システムとして利用され、自動的に情報を取得し、言語による対話を展開することができます。例えば、カスタマーサポートや言語翻訳などの分野で利用され、人と同様の自然な対話を可能にすることで、多くの人々にとって便利なツールとなっています。何ができるのか

ChatGPTは、テキストデータを学習して文章の作成、要約、修正などを行います。対話システムでの自然な応答が得意です。また、Web上のテキストデータから、数十億もの単語を収集し、自然言語処理のためのデータセットとニューラルネットワークを構築し、自然言語処理のモデルをトレーニングします。多様な分野の知識を持つことができます。

人事の仕事をどのように改善できるか

ChatGPTが言葉をうまく扱い文章を作成できることはわかりました。ここでChatGPTに人事の仕事をどのように改善できるかをたずねると、以下の返答がありました。1.応募者のスクリーニング:ChatGPTは、大量の履歴書やカバーレターを自動的に分析し、最適な候補者をスクリーニングすることができます。このため、人事担当者は時間と手間をかけて応募者を個別に評価する必要がなくなります。

2.面接の自動化:ChatGPTを用いると、面接の一部を自動化することができます。例えば、ChatGPTを使用して自動的に質問を作成し、応募者の回答を分析することができます。これにより、人事担当者の負担を減らすことができます。

3.従業員のトレーニング:ChatGPTは、従業員のトレーニングにも使用されています。例えば、ChatGPTを使用して自動的にトレーニング資料を作成することができます。また、ChatGPTを使用して従業員が質問に対する回答を学習することができます。

4.パフォーマンス評価の改善:ChatGPTを使用することで、従業員のパフォーマンスを自動的に評価することができます。これにより、人事担当者がより正確かつ公正に評価を行うことができます。

これらの方法により、ChatGPTは人事の仕事を効率的に改善することができます。

2.面接の自動化:ChatGPTを用いると、面接の一部を自動化することができます。例えば、ChatGPTを使用して自動的に質問を作成し、応募者の回答を分析することができます。これにより、人事担当者の負担を減らすことができます。

3.従業員のトレーニング:ChatGPTは、従業員のトレーニングにも使用されています。例えば、ChatGPTを使用して自動的にトレーニング資料を作成することができます。また、ChatGPTを使用して従業員が質問に対する回答を学習することができます。

4.パフォーマンス評価の改善:ChatGPTを使用することで、従業員のパフォーマンスを自動的に評価することができます。これにより、人事担当者がより正確かつ公正に評価を行うことができます。

これらの方法により、ChatGPTは人事の仕事を効率的に改善することができます。

このようにChatGPTは回答しましたが、これは私の質問に対して自然な文章で答えたにすぎませんので、ひとつひとつ内容を吟味してみましょう。

本当に業務改善につながるか

1.人材選抜における応募者のスクリーニング履歴書やエントリーシートのテキストを自動で読み込み評価する仕組みは以前からありました。2000年にリリースした当社初のオンラインアセスメントツール玉手箱にも履歴情報として自由に記述されたテキストを読み込み自動評価する機能を搭載していました。ChatGPTは無料で使える汎用的なツールですので、自由記述の自動評価がより一般的になっていくだろうと考えられます。

2.面接における質問と評価の自動化

ChatGPTは人との自然な会話が得意ですので、応募者に適した面接質問を作り、質問に対する回答から次の質問を作ることはできます。この際に重要なのは面接で応募者のどのような能力、適性、スキル、コンピテンシーなどを評価するかです。面接基準についてのインプットがなければ適切な評価はできません。面接基準をChatGPTに作成させることも可能ですが、そこで作られた面接基準が本当に適切なものかについては人による判断が不可欠です。また、ChatGPTが正しい評価すると信じるのは非常に危険です。AIは本当の意味で人の評価をしているわけではないということを忘れずに、評価結果とその根拠となる情報を人の目で確認する必要があります。

3.トレーニング資料の自動作成

トレーニング資料をChatGPTに作らせるのはよい使い方です。GPT4では、手書きの情報を読み取り、そのままの形でhtmlを書くことができるようになりました。Eラーニングのコンテンツを作らせることもできると思います。

4.パフォーマンス評価の改善

従業員のパフォーマンス評価を自動化するには、評価の対象となる情報が必要です。ChatGPTに読み込ませるための評価に関する情報の収集とその整理を人がするのであれば、敢えてChatGPTに評価をさせるまでもなく人が評価したほうが早く効率的です。評価をする際に最も時間がかかるのは、評価関連情報の収集です。情報収集はChatGPTに任せることができないとすれば、評価に関する業務改善は期待できません。

おわりに

ChatGPTは誰もが使えるAIとして画期的なツールです。発展途上の道具はどのようなものであっても注意して使わなければいけませんが、使わない人と使う人との間には大きな生産性の格差が生まれてしまうでしょう。人事の仕事は多くの個人情報や機密情報を扱う仕事ですので、安全に十分配慮して新しい道具の新しい使い方を発明していただきたいと思います。私も試行錯誤を続けていきます。 前編ではアセスメントにAIを活用するとどのような良い影響があるのかを述べました。後編は想定しておくべきリスクとリスクに対処するためのポイントをご紹介します。

AIを利用することの代表的なリスクは、「企業の評判リスク」「法的リスク」の2つです。

企業の評判リスク:

ソーシャルメディアの浸透により、個人の発言力は高まっています。AIによって不当に扱われたと感じる個人がいた場合、その影響は計り知れません。例えば、本人の同意がない情報をAIの学習データとして使った、本人に対して説明もなくキャリアパスをAIに操作されていた、というような事実が明るみに出た場合、従業員との信頼関係を損なうだけでなく、社会的な信用問題にまで発展することは想像に難くありません。

法的リスク:

日本の個人情報保護法、EUの一般データ保護法(GDPR)など、個人の情報を取り扱う上での法整備は世界中で整備されています。特にGDPRでは、AIの活用について公平性の原則に従い、どのようなデータを活用するのかに関する十分な説明を対象者に行うよう求めています。

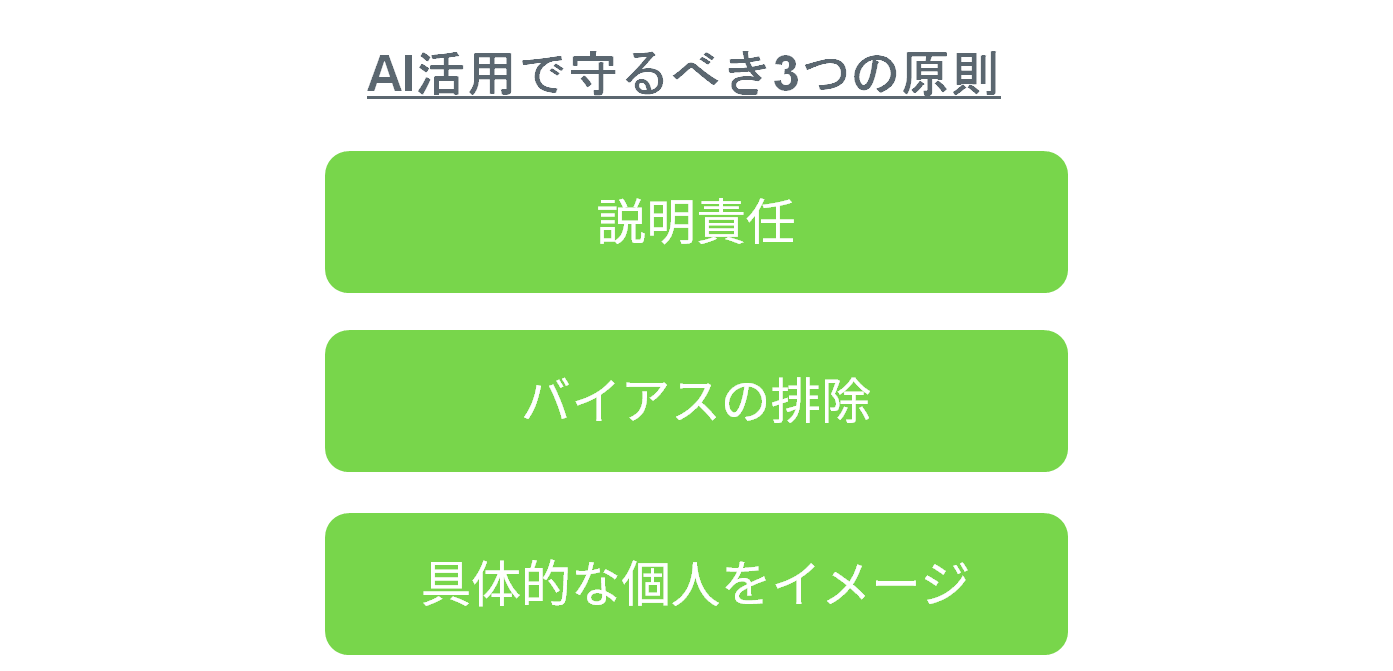

AI活用で守るべき3つの原則

1.説明できるようにする。AIによる予測モデルは複雑になりがちです。AIが大量のデータを学習すればするほど、判断の過程を人間が理解できないものになりがちです。「統計上の成功確率が高いので、異動してください。」の一言で納得する人はいませんので、判断に至った過程を説明できるように準備する必要があります。どのような変数がどの程度影響していて、概念的にも内容的にも妥当なものであることを理解してもらう必要があります。

2.既存のバイアスを排除する。

AIは人間の判断を学習します。将棋や囲碁のように勝ち負けとルールがはっきりしている中ではバイアスの入る余地はありませんが、人事的な判断には少なからずバイアスが含まれています。そのバイアスが入った情報をAIに学習させれば、偏った判断を下すAIが出来上がります。学習データの選定にあたっては、バイアスが極力取り除かれたデータを用意しましょう。

3.具体的な個人に目を向ける。

AIの活用においては、統計的な成功確率を高めることに目が行きがちです。一方で、AIが導き出した判断を受ける個人にとっては自分のキャリアや人生がかかっています。倫理的に問題ない判断になっているかを確認するだけでなく、その判断を本人に伝える時に、どういった伝え方が双方にとって有益なのかを考える必要があります。

おわりに

新しい技術を活用する時にはそれを扱う側の人間性が問われる、というのはいつの時代も変わりません。マハトマ・ガンディーが掲げていた7つの社会的罪の一つに「人間性なき科学」が存在していたことを思い出しました。多くの人の共感を呼ぶようなAIの活用の仕方を私自身模索していこうと思います。ビジネスのあらゆる場面で人工知能(以下AI:Artificial Intelligence)の活用が進み、人事領域においてもAIを活用したサービスが次々と生み出されています。それらのサービスは多種多様で、中にはAIを活用していると喧伝しているものの本質的には従来型のサービスと何ら違いが無いようなものも存在しています。人事領域でAIを活用することは大きな可能性を秘めている一方で、使い方を間違えると企業と従業員の信頼関係を大きく損なう危険性があります。

今回のコラムでは、前編と後編に分けて、AIを人事アセスメントに用いるとどのような良い事があるのかを整理した上で、後編においてはどんなリスクが発生するのか、それらのリスクを管理するために守るべき原則は何なのかを考察します。

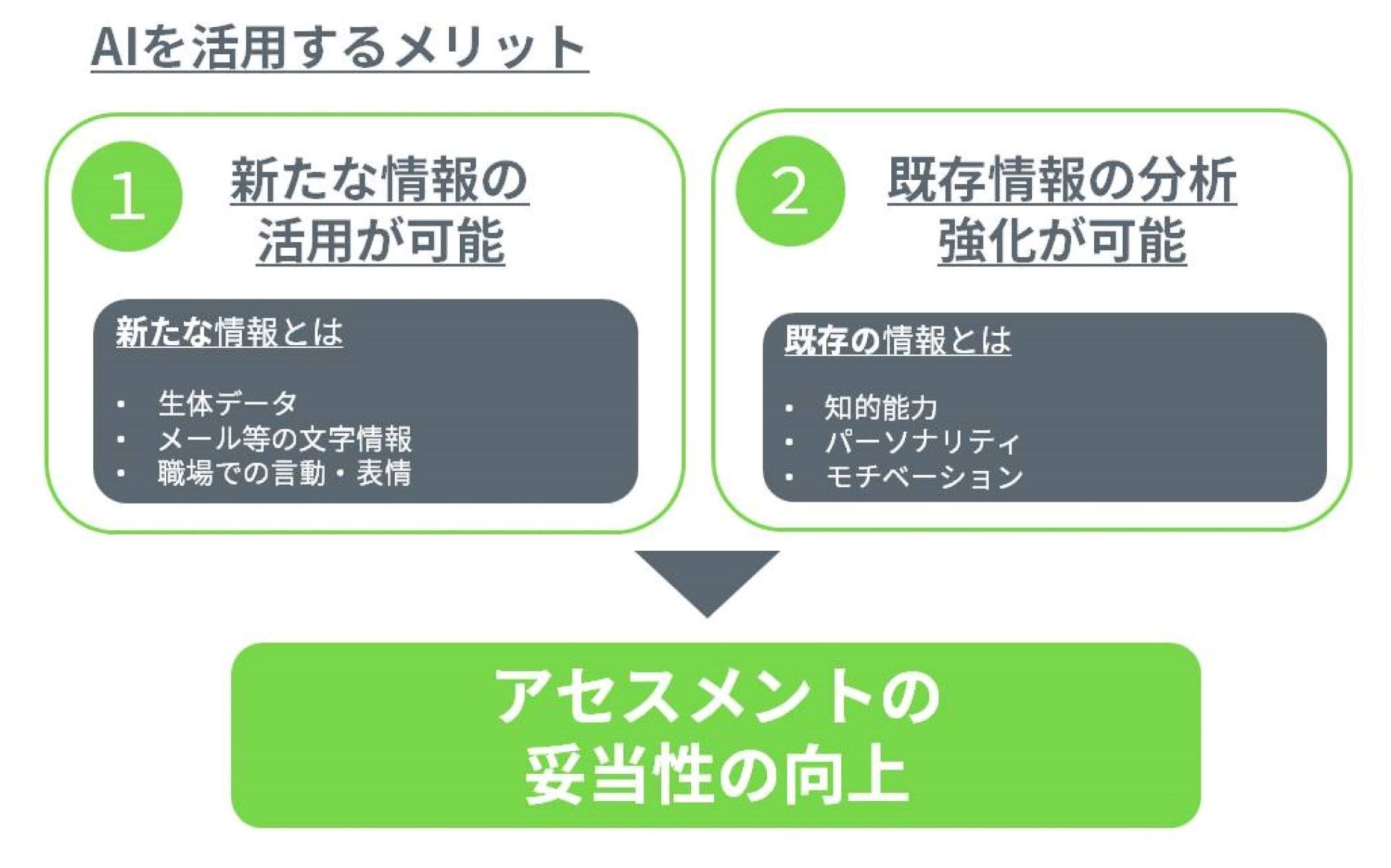

AIとアセスメント

AIという用語の定義は研究者により異なり、明確な定義を述べる事は難しいですが、「人間のように思考・判断するように、人工的に作成されたコンピュータープログラムやアルゴリズム全般」のことを指しています。2000年代から、大量のデータを用いてコンピューター自らが学習し知識を獲得する「機械学習」の発達に伴い、多様な場面で実用化が進みました。アセスメントの文脈で言えば、AIがもたらす変化は次の2点であると考えられます。

1.新たな情報の活用が可能になる

具体的には、メール等の文字情報、職場での言動・表情、生体データ等などの情報を指しています。デジタル技術の向上により多様な情報をデジタルデータ化する事が従来よりも簡単になっています。どこまでの情報を個人に紐づけて分析することが倫理的に問題ないかという議論はさておき、同僚とのビデオ会議の中で、誰が、どのような表情で、どんな発言を行い、周囲はそれに対してどのような反応であったかはすべてデータ化されており、これらの情報を基にリーダーシップ等の能力を推定する事は夢物語ではなくなりつつあります。(ただし、現時点ではしっかりとした科学的根拠を持って妥当なアセスメントができるという技術が確立されているわけではないので、後述するリスクと合わせて考えていく必要があります。)

2.既存の情報の分析能力が強化される

既存の情報とは、アセスメントで得られるようなパーソナリティ、知的能力、モチベーションなどの情報のことを指しています。既存のアセスメント情報を分析・活用する際にAIを用いることにより、従来の統計学的な分析では得られることのできなかった知見が素早く簡単に取得できるようになります。また、どの設問が測定したい能力と相関が強いのかを検証することにより、妥当性を落とさずにアセスメントの時間を短縮するような事も可能です。いずれも測定手法自体の変容というより、そこから得られる情報の有効活用をするためにAIを駆使するという事です。

AIを活用することの具体的なメリット

AIを適切に活用する事で得られる代表的なメリットは、「妥当性の向上」「バイアスの軽減」の2つです。妥当性の向上:

前述の通り、大量のデータを適切に分析する事によって、従来のアセスメントでは為し得なかった水準で人や組織のパフォーマンスを予測する事が期待できます。人を選抜・異動させる時に、「その人の新たな職務における成功確率の予測」や「その人が加入する組織の風土がどう変容するかの予測」に関する精度が向上すれば、意思決定の過程に大きなインパクトを与えます。

バイアスの軽減:

特に人が人を評価するような場合、ハロー効果に代表されるような多様なバイアスが評価結果に反映される可能性がある事はよく知られている事実です。人間の特徴ともいえる主観的な判断は有用であることも多いですが、同じ情報を同じ様に安定的に評価するという事においては明らかにコンピューターの方が優れています。「仕事はできそうだけど、なんとなく当社っぽくないので高く評価できない」なんていう評価の仕方はコンピューターには逆に難しいのです。

前編では、AIがアセスメントの実施・運用に対してどのような影響を与え、どんなメリットが生まれるのかを考察してみました。後編においては、AIが持つリスクについて言及し、リスクを抑えつつAIを活用するための原則を考えてみたいと思います。